Google minęło się z prawdą ws. Gemini. Demonstracyjny film to fake

Rok po udostępnieniu ChatGPT swoją odpowiedź przygotowało Google. Gemini, bo taką nazwę otrzymał duży model językowy z Mountain View, przez wielu został już okrzyknięty triumfatorem w starciu, choć nie brakuje głosów przeciwnych. Zwłaszcza że firm prezentujący rzekome możliwości Gemini został częściowo sfabrykowany.

Google odpowiada na ChatGPT

W stosunku do pierwszych faz rozwoju modelu OpenAI, w Gemini widać kilka różnic. Bez wątpienia wynikają one z analizy tego, co się udało w procesie budowania GPT i ChatGPT, a co nie. W efekcie Gemini już na stracie występuje w trzech wariantach oraz obsługuje różne typy danych: nie tylko język naturalny, ale tez obrazy i dźwięk, o co ChatGPT było wzbogacane z czasem.

Pojawiły się liczne analizy na temat przewagi ChatGPT nad Gemini oraz Gemini na ChatGPT, których sprzeczność pokazywała jak w soczewce, że brakuje nam obiektywnych metod oceny skuteczności LLM-ów. Nawet testy przeprowadzane w ramach „benchmarków” mogą być dobierane skrajnie selektywnie, tak aby wykazać przewagę wybranego LLM-a nad drugim.

Google prezentuje Gemini – duży model językowy, który powalczy z ChatGPTMożliwościom Gemini zadano kłam

Zaledwie dzień po premierze Gemini zaliczyło już swoją pierwszą wizerunkową wpadkę. I dość poważną – olśniewające demonstracje modelu nie przedstawiają jego aktualnych możliwości. Materiały filmowe prezentujące podczas premiery były przynajmniej częściowo zmanipulowane, a według bardziej krytycznej części komentatorów – całkowicie sfabrykowane.

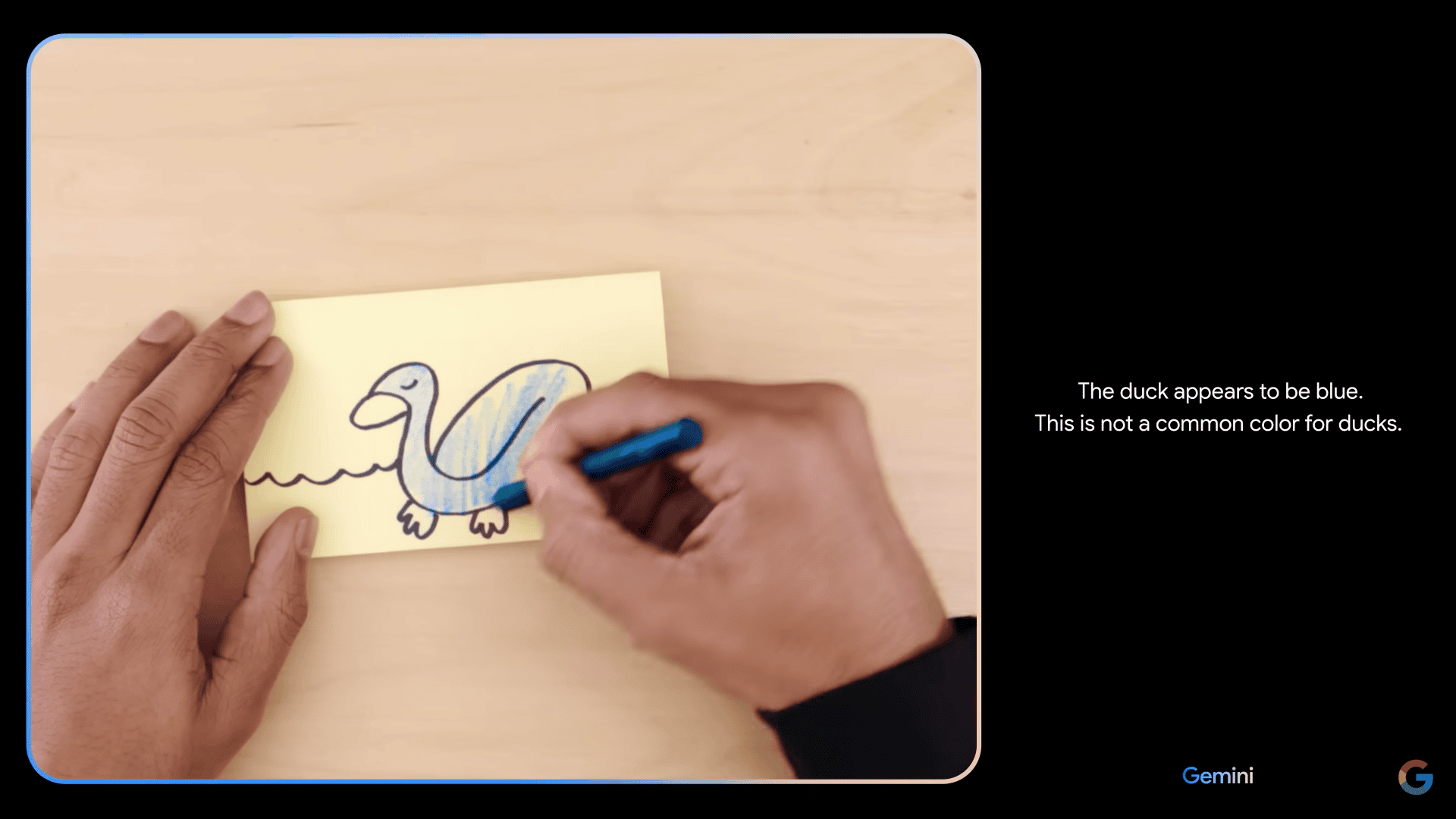

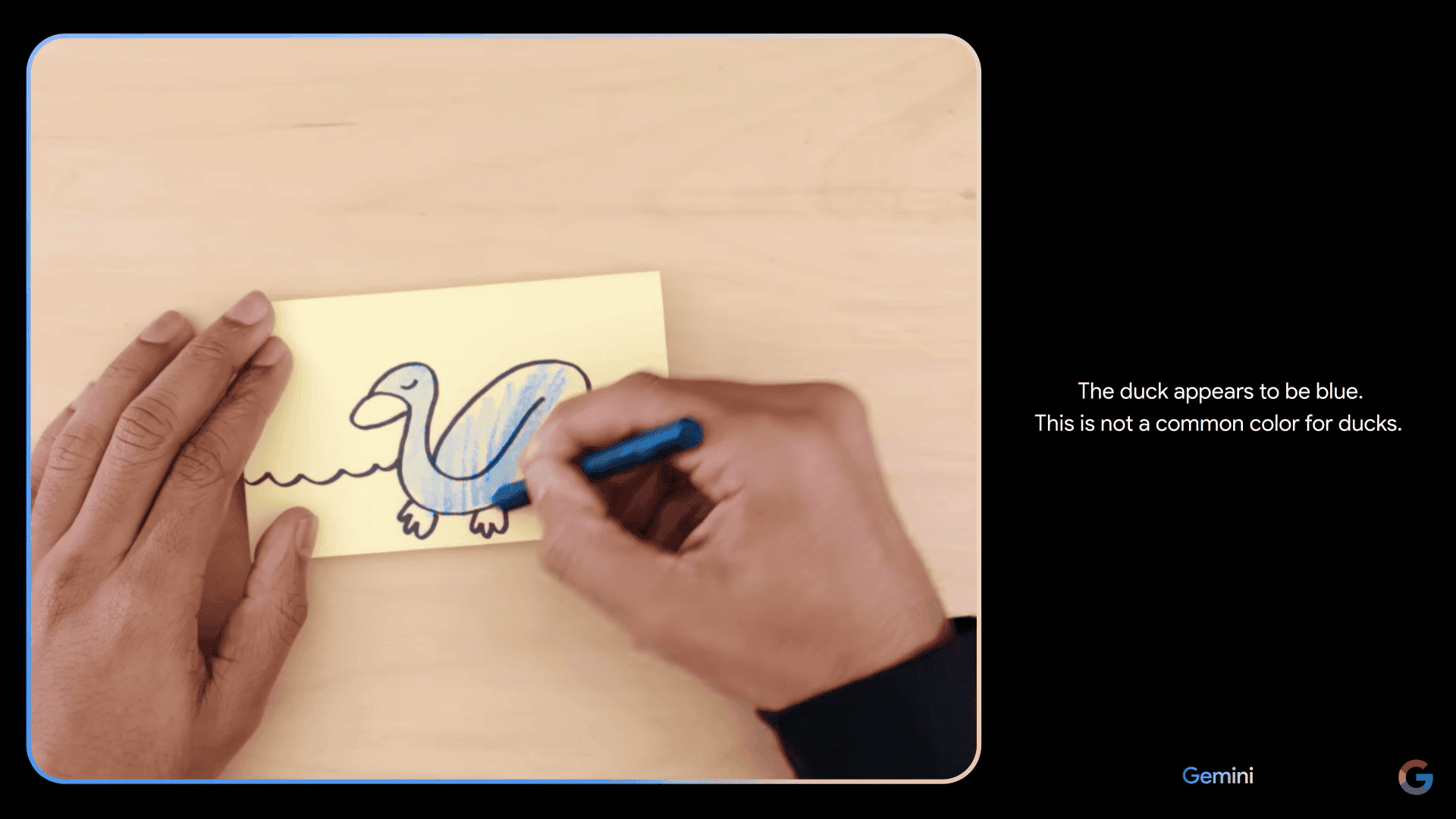

Film przedstawia scenariusz wykorzystania Gemini, w którym model na podstawie analizy materiału wideo dokonywał opisu rysowanych obiektów. Sprawiało to takie wrażenie, jakby model był na bieżąco w stanie opisywać kolejne elementy rysunku wprowadzane krok po kroku, aktualizując swoje wnioski. Poza tym serwował ciekawostki na temat rysowanej przez testującego kaczki.

Google potwierdza, że film to manipulacja

W rezultacie demo przekonywało, że Gemini w największym wariancie Ultra (docelowe zastosowanie to centra danych) nie tylko jest w stanie dokonać natychmiastowego rozpoznawania zmieniających się realiów, ale jednocześnie dokonywać generalizacji i pogłębionej analizy. Dokonując tych czynności, przetwarza mowę testera na tekst i analizuje je oraz obsługuje odwrotny proces, generując mowę.

Eksperci zdający sobie sprawę z tego, jak ogromnych zasobów wymagałaby symultaniczność dokonywana na takim poziomie i przy zaprezentowanej precyzji, podważyli autentyczność demonstracji. Jak się okazało, mieli rację. Google przyciśnięte do ściany potwierdziło, że efekty pracy Gemini Ultra uzyskiwano w inny sposób – używano statycznych obrazków i tekstu, a nie zaprezentowanego filmu.

Wyścig zbrojeń i wojenna propaganda

Zapewne już niedługo wszyscy zapomną o wpadce Google, niemniej jest ona przejawem szaleństwa, jakie ogarnęło Doliną Krzemową w kwestii rozwoju sztucznej inteligencji. Do czynienia mamy z prawdziwym wyścigiem zbrojeń, w którym – podobnie jak to ma to miejsce podczas prawdziwych defilad i techniki wojskowej – zdarzają się makiety i fałszywki.

Zamiast zdrowej konkurencji czy ram bezpieczeństwa, otrzymujemy pozbawioną resztek zdrowego rozsądku rywalizację na to, która korporacja ma większy LLM i budzącą się jak zwykle z ręką w nocniku legislaturę.